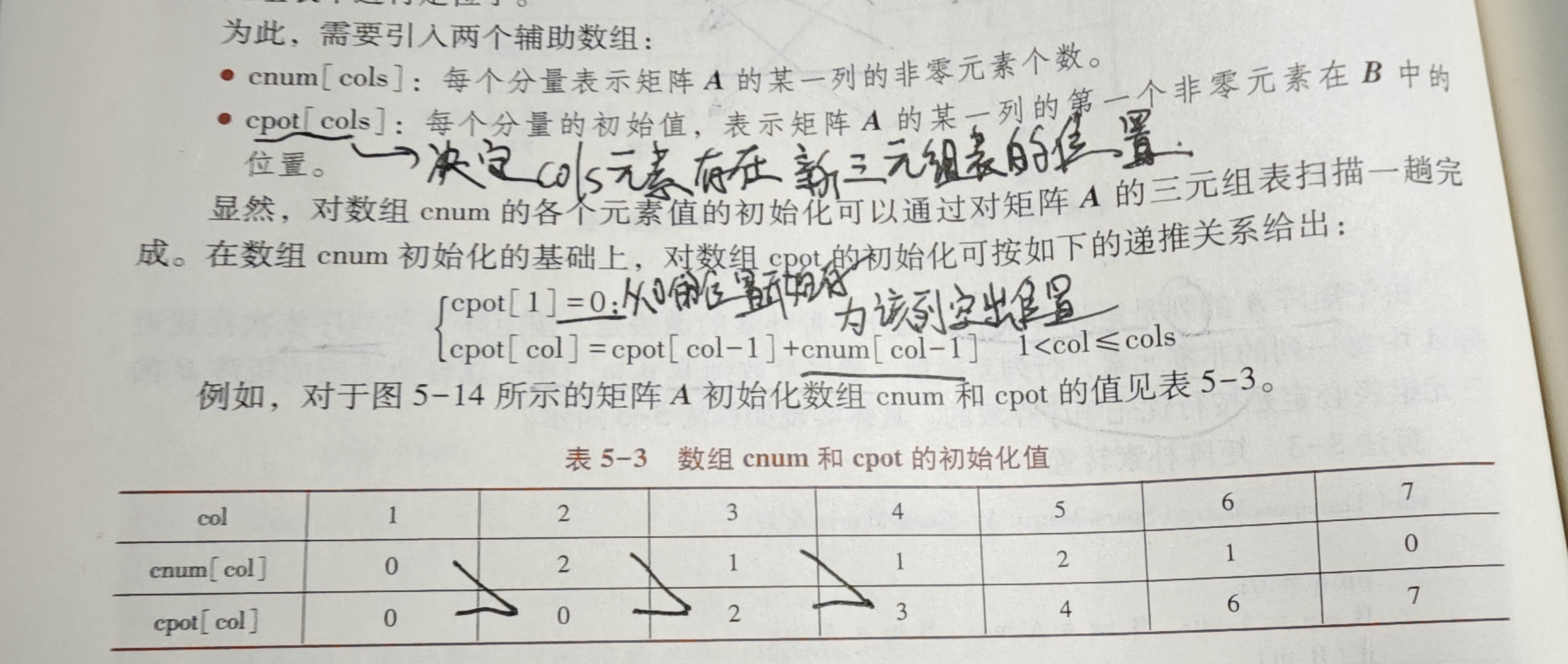

视频异常检测初步了解

传统方法检测异常样本:

高斯分布 Gaussian Distribute

高斯混合模型 Gaussian Mixture Model

深度学习方法下的异常检测:

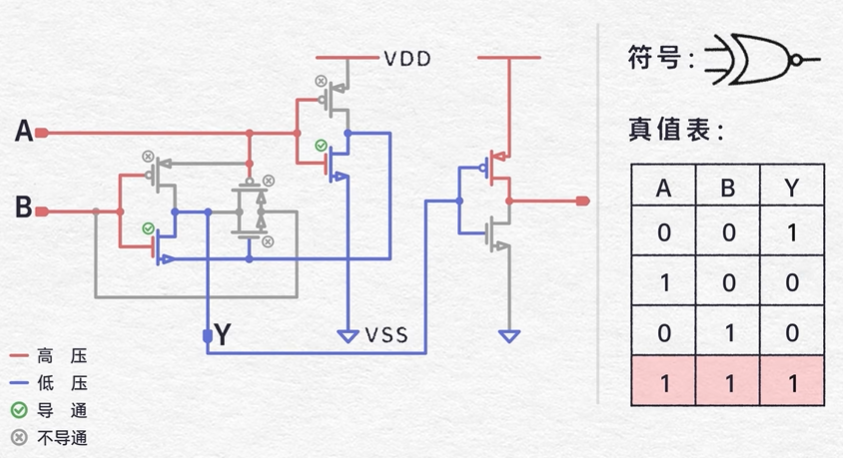

两种主流的异常检测任务:

重构任务

Reconstruction:图像通过深度神经网络DNN输出一张重构图像,通过损失函数,先训练调整DNN,测试结果由AUC评判(AUC(Area

Under the Curve)是用于评估分类模型性能的一个重要指标)

预测任务

Prediction:连续输入图像,预测新图像,用预测与非预测比较

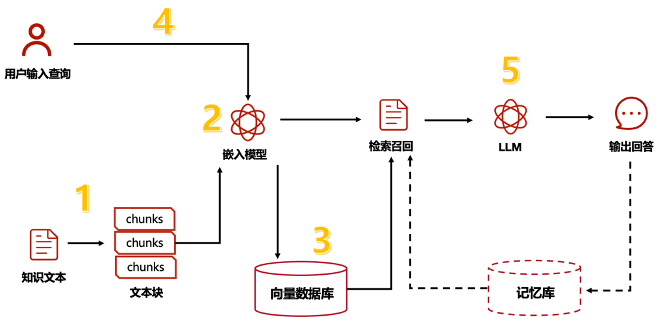

自动编码器 Auto-Encoder:U-Net

是一种用于图像分割的深度学习模型,主要特点是采用了编码器-解码器结构(也叫对称结构),并在编码器和解码器之间引入了跳跃连接(skip

connections)

编码器(Contracting

Path) :这一部分类似于卷积神经网络(CNN),用于提取输入图像的特征。

瓶颈层(Bottleneck) :编码器和解码器之间的连接层,负责处理最深层次的特征。

解码器(Expansive

Path) :这一部分用于将编码器提取的特征还原回原始图像的大小。

跳跃连接(Skip

Connections) :解码器部分会与编码器的对应层进行直接连接,从而帮助模型在恢复空间分辨率的过程中更好地保留细节信息。

v2-39073bacc426f0e464b53336c83e19da_1440w

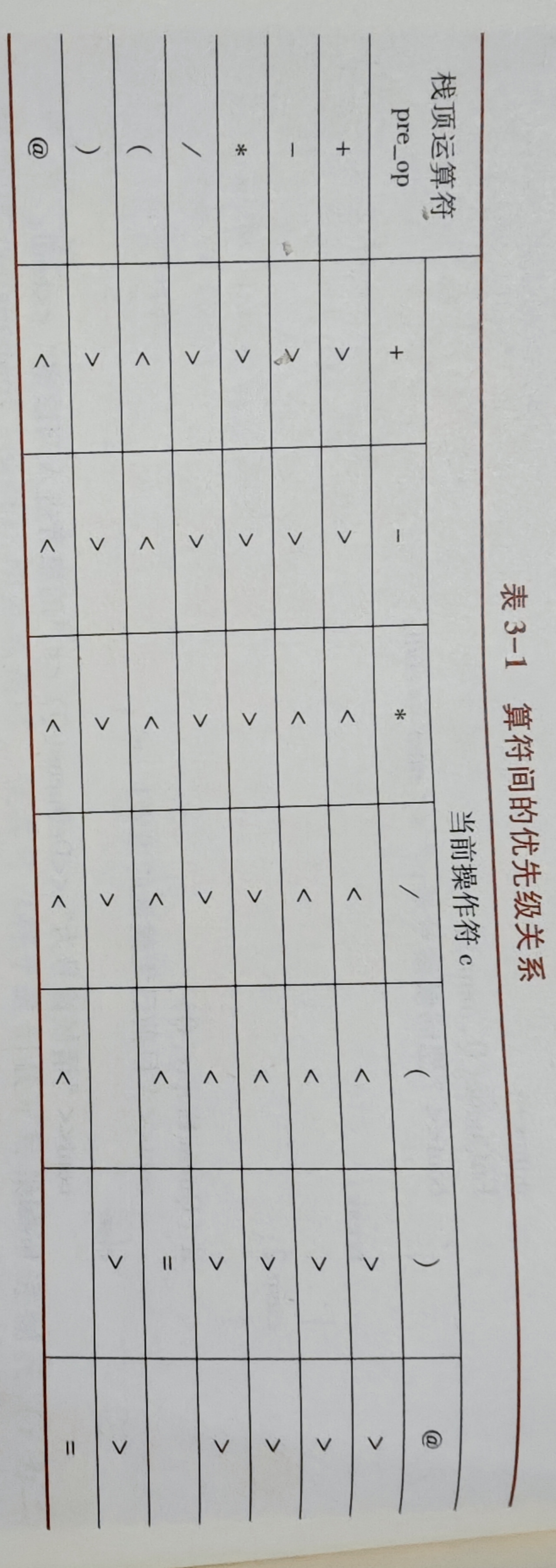

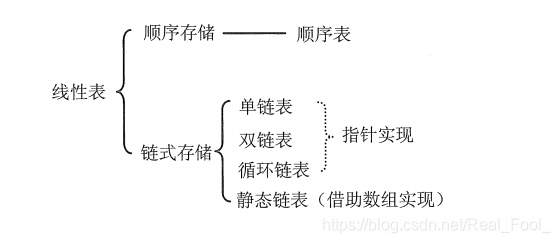

根据学习方法分类:

无监督学习 unsupervised learning 只有正常样本训练

半监督学习 weakly spervised learning 以不平衡的样本比例训练

监督学习 spervised learning 都训练

视频异常检测领域未来挑战:

异常检测视频大部分采用mini-batch训练方法,非常消耗时间和资源,无法实时进行视频检测

现实的数据集,模型难以训练

异常的情况定义模糊

模型的迁移性差,shanghaiTech的数据集是多摄像头融合的数据集,大部分数据集表现一般

了解yolo

YOLO(You Only Look Once)系列算法是计算机视觉领域中重要的目标检测技术 。凭借其高效的实时处理能力,YOLO被广泛应用于视频监控、自动驾驶等多个领域。

论文一:Human

Action Recognition from Various Data Modalities: A Review

概述

人类动作识别(Human Action Recognition,

HAR) 旨在理解人类的行为,并为每个行为分配一个标签。

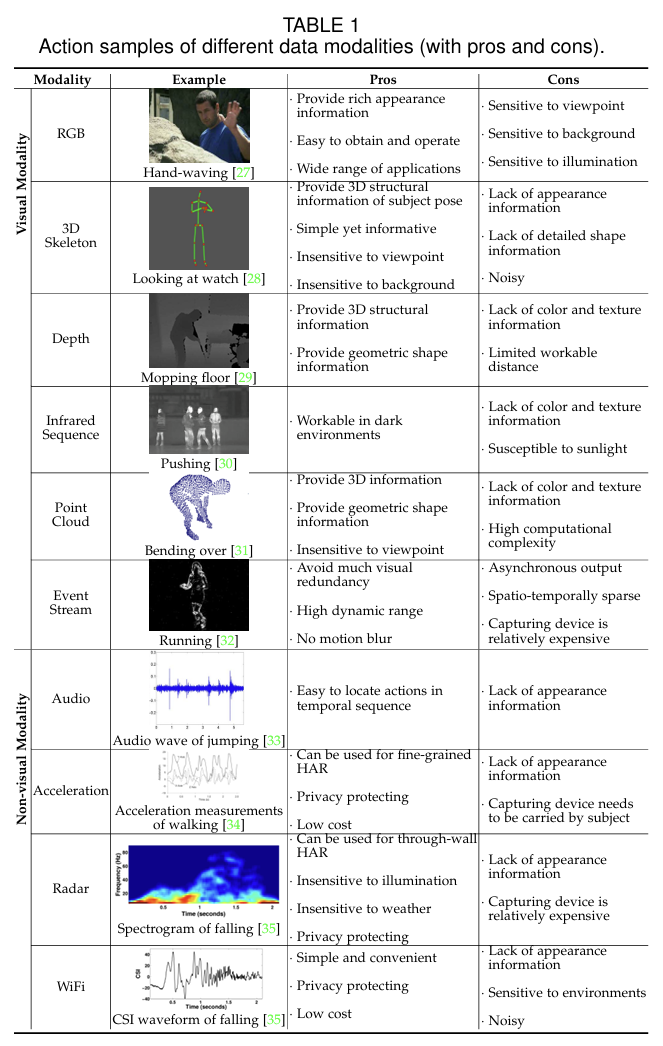

多种不同的数据形态都可以用来表示人类的动作和行为。这些模态可以分为2类:视觉模态和非视觉模态

视觉模态和非视觉模态的主要区别在于:视觉模态的数据对人类行为的表示相对直观,但是非视觉模态的数据则不是。视觉模态主要包括:如RGB,骨架,深度,红外,点云,事件流(event

stream)等数据模态,而非视觉模态则主要包括音频,加速度,雷达,wifi信号等数据模态

然而,由于不同的模态对 HAR

具有不同的优势和局限性,因此多种数据模态的融合和跨模态的知识传递以提高

HAR 的准确性和稳健性,近年来也受到了极大的关注

[23],[24]。更具体地说,融合是指将两种或多种模态的信息组合起来,以识别动作

该综述对基于不同数据模态的深度学习HAR方法的最新进展做了一个综合调研。介绍调研的主要内容分为三部分

当前主流的单模态深度学习方法

当前主流的多模态深度学习方法,包括基于融合(fusion)和协同学习(co-learning)的学习框架

当前HAR任务的主流数据集

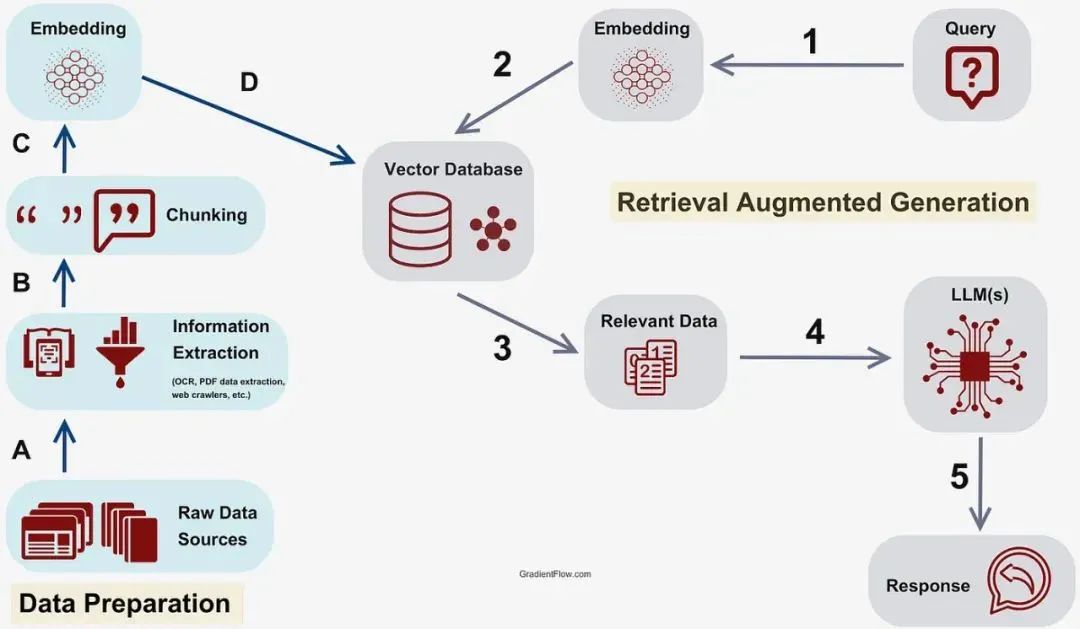

单一模态 SINGLE MODALITY

RGB模态 RGB MODALITY

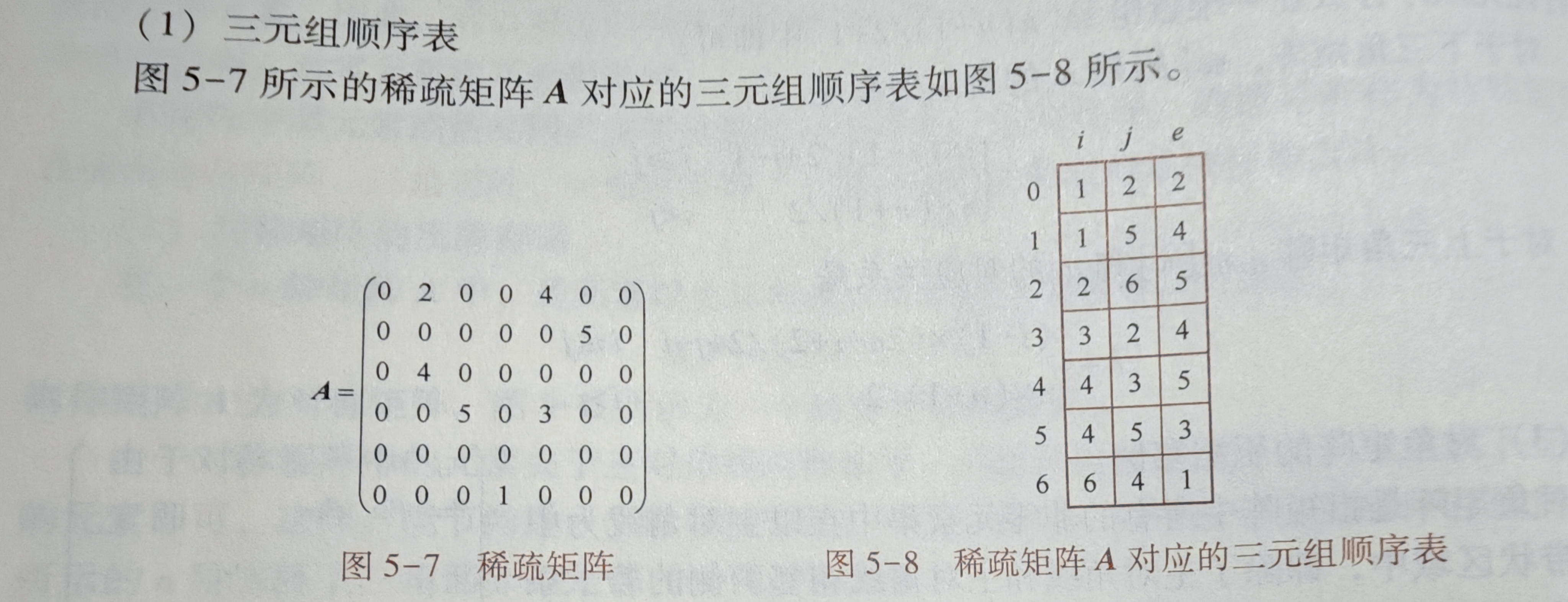

RGB 模态通常是指由 RGB

相机捕获的图像或视频(图像序列),旨在重现人眼所见。

RGB模态优点主要有:(1)RGB数据容易收集,通常是最常用的数据模态。(2)RGB模态包含所捕获的场景上下文的信息。(3)基于RGB的HAR方法也可以用来做pretrained

model。

缺点主要有:(1)由于RGB数据中存在背景、视点、尺度和光照条件的变化,所以在RGB模态中进行识别通常具有挑战性。(2)RGB

视频通常具有较大的数据量,导致在为 HAR

的时空环境建模时会产生高计算成本。

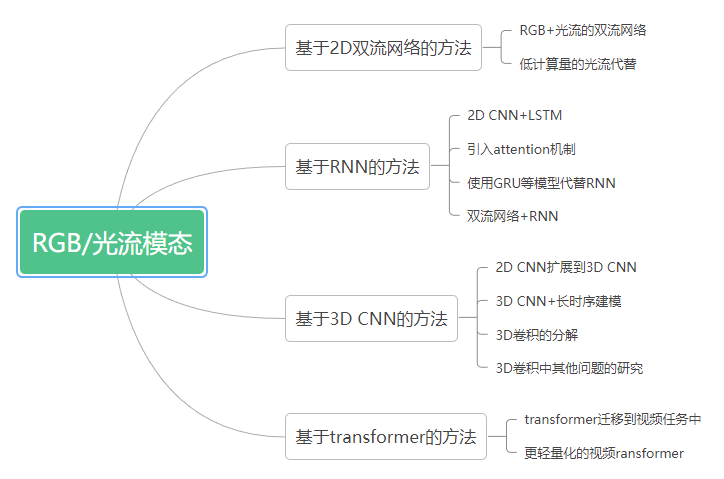

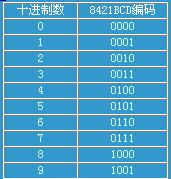

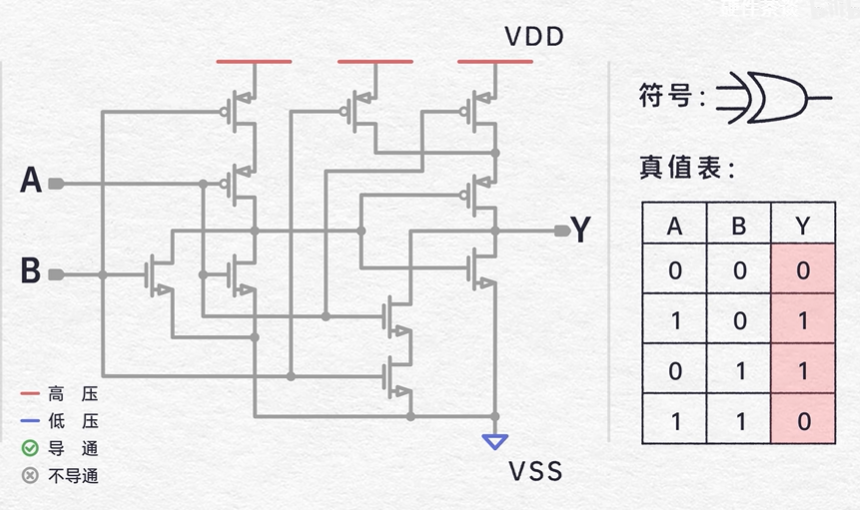

下面介绍面向基于 RGB 的 HAR 的高级深度学习,主要可分为四大类,即双流

2D 卷积神经网络 (CNN)、递归神经网络 (RNN)、3D CNN 和基于 Transformer

的方法

v2-4ec2f54d013bb5ab6996585c53f7755d_1440w

sadasd

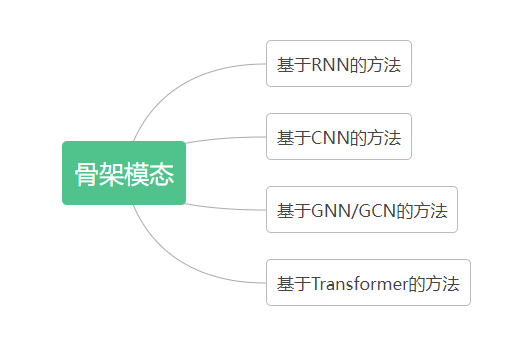

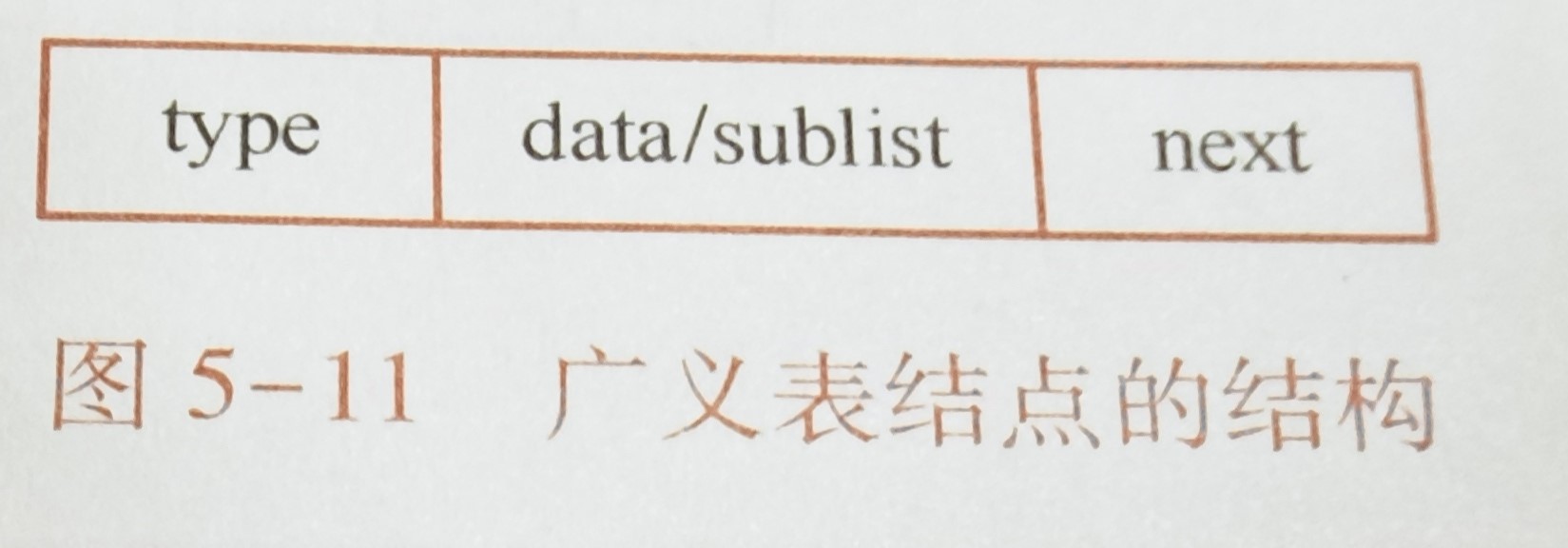

骨骼模态 SKELETON MODALITY

骨骼序列编码人体关节的轨迹,这些轨迹表征了信息丰富的人体运动。因此,骨架数据也是

HAR 的合适模式。

骨架数据提供的是身体结构与姿态信息,其具有两个明显的优点:(1)具有比例不变性。(2)对服装纹理和背景是鲁棒的。

但同时也有两个缺点:(1)骨架信息的表示比较稀疏,存在噪声。(2)骨架数据缺少人-物交互时可能存在的形状信息。

v2-f3f49680590c848b02f3e7911c5d7d3c_1440w

深度模态 DEPTH MODALITY

深度图其中像素值表示从给定视点到场景中的点的距离信息。深度模态通常对颜色和纹理的变化具有鲁棒性,提供了可靠的人体三维结构和几何形状信息,因此可用于

HAR。随着技术的发展,现在已经有多种设备可以捕获场景中的深度图。现有的对深度数据学习的方法大多数还是利用CNN提取深度图中的feature。深度数据可以提供几何形状信息,但是对外观数据的提供是缺失的,所以深度数据通常不单独使用,而是与其他模态的数据融合使用。

红外模态 INFRARED MODALITY

通常,红外传感器不需要依赖外部环境光,因此特别适用于夜间

HARat。红外传感技术可分为有源和无源两种。一些红外传感器(如

Kinect)依赖于主动红外技术,该技术发射红外线并利用目标反射光线来感知场景中的物体。在目前基于深度学习的方法中,比较多的做法是把红外图像作为其中一个stream输入双流或多流网络中。红外数据以其不需要依赖外部环境的可见光的特点,特别适合于夜间的HAR,但是,红外图像也有着对比度低和信噪比低的固有缺点。

点云模态 POINT CLOUDMODALITY

点云数据由许多点集合组成,这些点表示空间参考系统下目标的空间分布和表面特征。获取

3D 点云数据有两种主要方法,即 (1) 使用 3D 传感器,例如 LiDAR 和

Kinect,或 (2) 使用基于图像的 3D 重建。点云作为一种 3D

数据模态,具有强大的能力来表示主体的空间轮廓和 3D 几何形状,因此可以用于

HAR。但是点云中通常存在噪声和高度不均匀的点分布。

事件流模态 EVENT STREAM

MODALITY

事件照相机(event

camera)可以捕捉照明条件的变化并为每个像素独立产生异步事件。传统的摄像机通常会捕捉整个图像阵列,而事件摄像机仅响应视觉场景的变化。事件照相机能够有效地滤除背景信息,而只保留前景运动信息,这样可以避免视觉信息中的大量冗余,但是其捕捉到的信息通常在时间和空间维度上是稀疏的,而且是异步的。因此一些现有的方法主要聚焦于设计事件聚合策略,将事件摄像机的异步输出转换为同步的视觉帧。

音频模态 AUDIO MODALITY

音频信号通常与视频信号一起提供,由于音频和视频是同步的,所以音频数据可以用定位动作。因为音频信号中的信息量是不足的,所以单独使用音频数据执行HAR任务相对比较少见。更常见的情况是音频信号作为HAR的补充信息,与其他模态(如rgb图像)一起使用。

后续

还有加速度模态,雷达模态,wifi模态,我先不了解,后续若有需要再完善知识

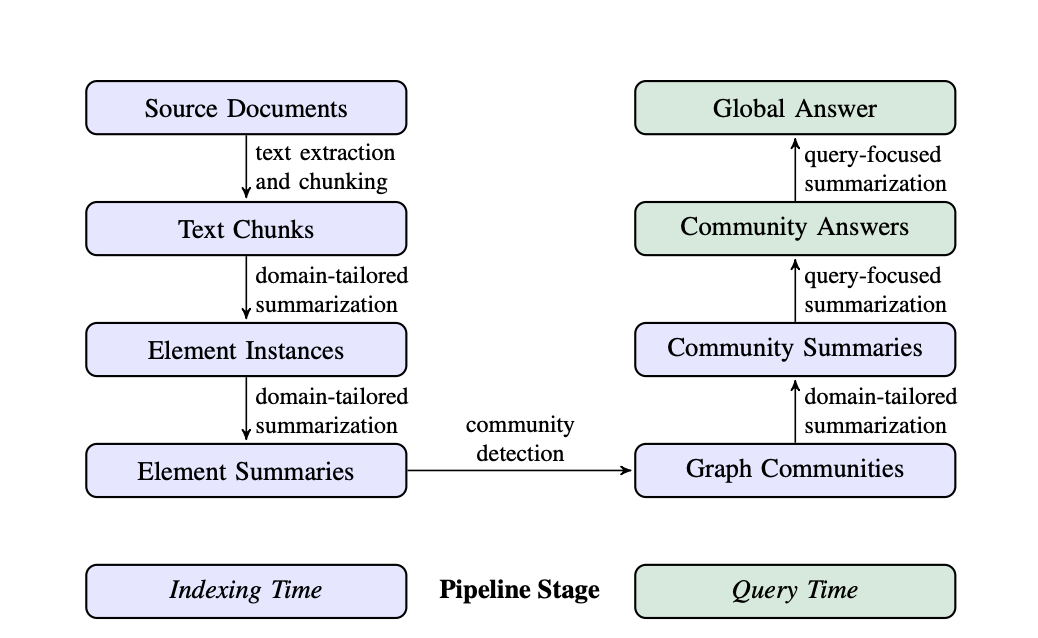

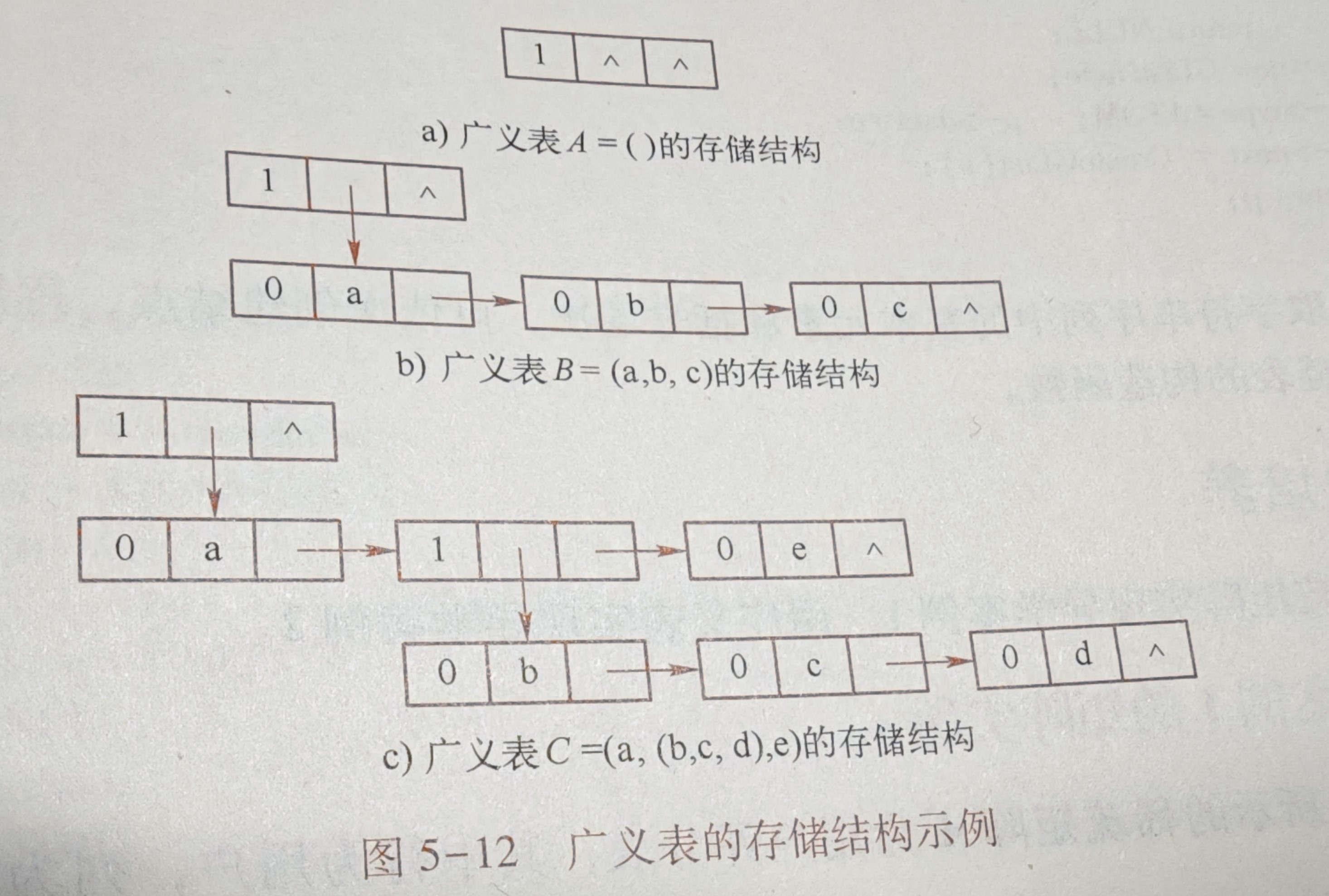

多模态 MULTI-MODALITY

在现实生活中,人类经常以多模态认知方式感知环境。同样,多模态机器学习是一种建模方法,旨在处理和关联来自多种模态的感觉信息[358]。通过聚合各种数据模态的优势和功能,多模态机器学习通常可以提供更强大、更准确的

HAR。

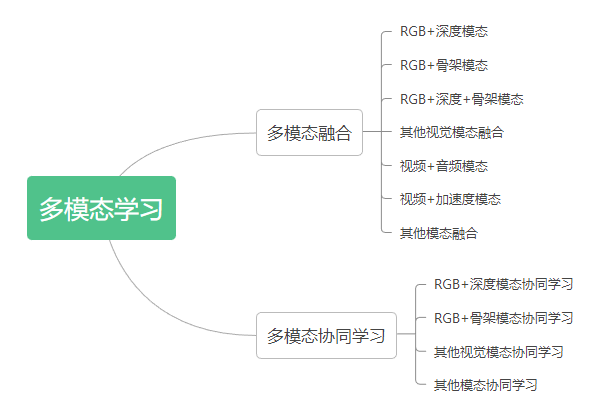

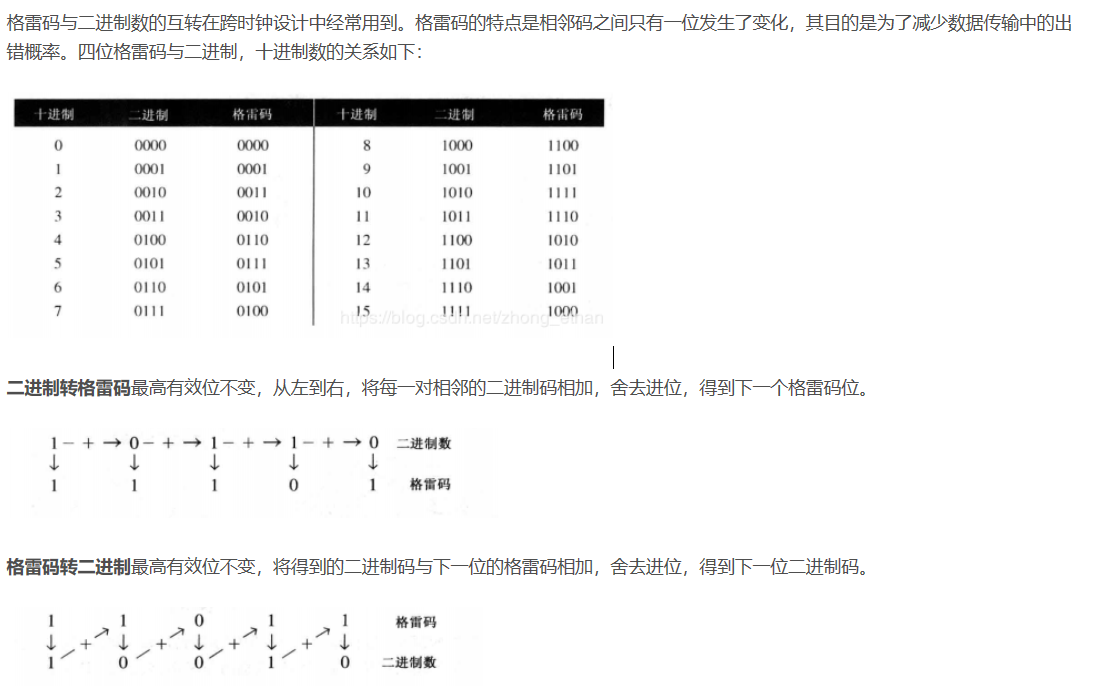

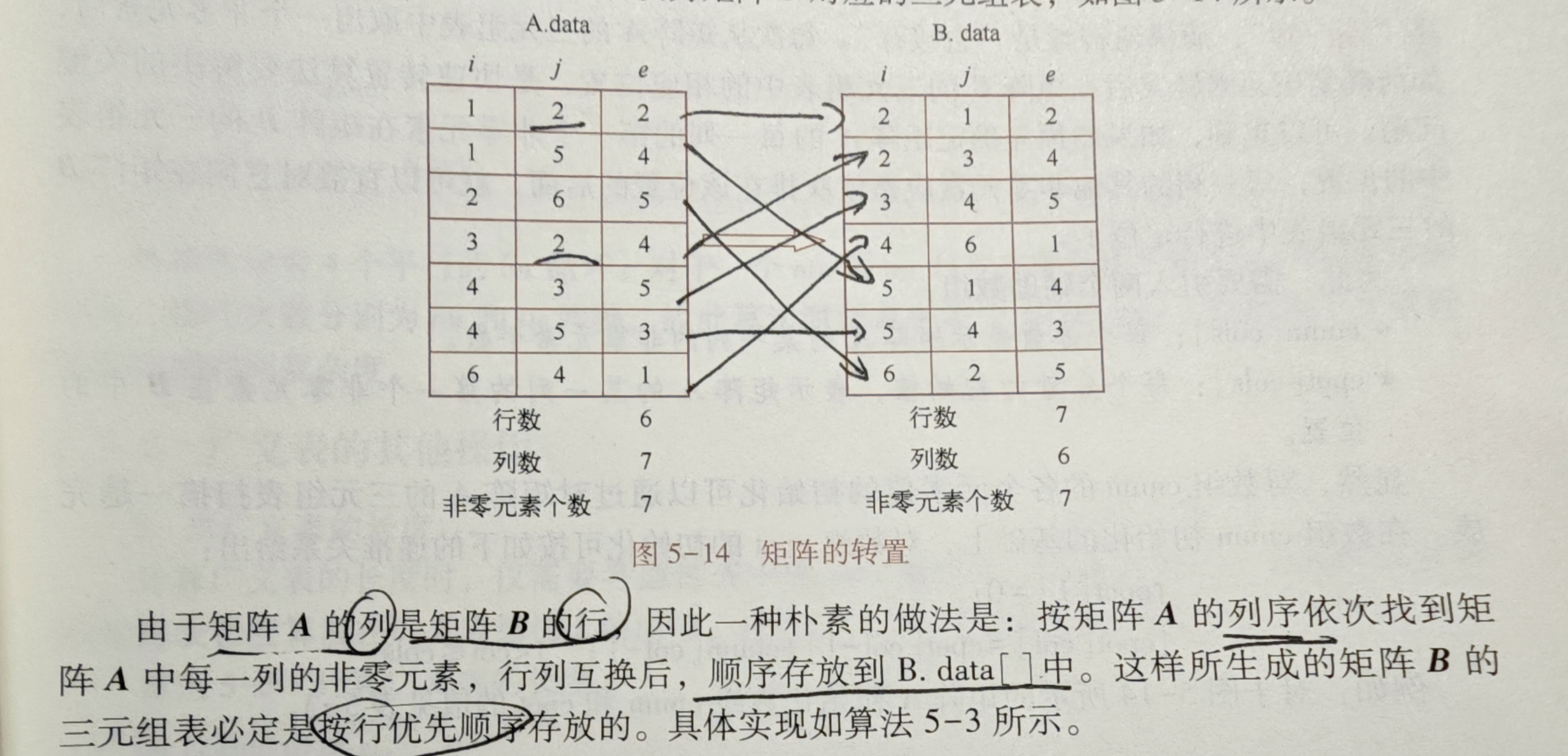

多模态学习方法主要有两种,融合(fusion)和协同学习(co-learning)。其中融合指的是对来自两个或更多模态的信息进行集成,并将其用于训练或推理,而协同学习指的则是对不同模态之间的知识进行迁移。图4展示了多模态学习方法的分类

v2-04335982349266acffdb93355ce2686c_1440w

HAR任务中的多模态融合

模态融合的目的是利用不同数据模态的互补优势,以达到更好的识别性能。现有的多模态融合方案主要有两种:(1)评分融合(score

fusion),即对不同模态输出的score做融合,例如使用加权平均或学习一个分数融合模型。(2)特征融合,即对来自不同模态的特征进行组合。数据融合(在特征提取之前就融合不同模态的输入数据)可以看成是特征融合,因为某一模态的数据数据可以被视为该模态的原始特征。

依据输入模态的不同,现有的多模态融合方法大概可以分为视觉模态之间的融合,与视觉+非视觉模态之间的融合两种

视觉模态之间的融合

RGB+深度模态:RGB和深度模态分别能够捕捉外观信息和3D形状信息,因此它们具有比较强的互补性。

RGB+骨架模态:骨架模态可以提供身体位置和关节运动信息,同样和RGB模态是互补的。[28]提出了一个双流深度网络,两个stream分别是CNN和RNN,用以分别处理RGB和骨架数据,融合方式同时尝试了特征融合和分数融合,并发现应用特征融合策略可以取得更好的效果。

深度图+骨架模态:[31]将身体的每个部分与其他部分之间的相对几何关系作为骨架特征,将不同身体部分周围的深度图像块作为外观特征,以编码身体-对象和身体部分-身体部分之间的关系,进而实现可靠的HAR。

RGB+深度图+骨架模态:这类方法大多是前文提到了三类多模态融合方法的扩展。

视觉模态+非视觉模态的融合

视频与音频的融合:前文中已经提到,音频可以为视频的外观和运动信息提供补充信息。所以目前已经有一些基于深度学习的方法来融合这种模态的数据

视频与加速度模态的融合

其他类型的模态融合:[43]的核心思想是将非RGB模态的数据,包括骨架、加速度和wifi数据都转换成彩色图像,然后送入CNN中。

HAR任务中的多模态协同学习

多模态协同学习旨在探索如何利用辅助模态学习到的知识帮助另一个模态的学习,希望通过跨模态的知识传递和迁移可以克服单一模态的缺点,提高性能。多模态协同学习与多模态融合的一个关键区别在于,在多模态协同学习中,辅助模态的数据仅仅在训练阶段需要,测试阶段并不需要。所以多模态协同学习尤其适用于模态缺失的场景。此外对于模态样本数较小的场景,多模态协同学习也可以起到一定的帮助作用。

视觉模态的协同学习

RGB和深度模态的协同学习

RGB和骨架模态的协同学习。如[48]利用CNN+LSTM执行基于RGB视频的分类,并利用在骨架数据上训练的LSTM模型充当调节器,强制两个模型的输出特征相似。

视觉和非视觉模态的协同学习 第一种类型是在不同模态之间进行知识的迁移,如[50]中的teacher

network使用非视觉模态训练,而student

network使用RGB模态作为输入,通过强制teacher和student的attention

map相似以弥补模态间的形态差距,并实现知识的提炼。

第二种类型是利用不同模态之间的相关性进行自监督学习,比如[51]分别利用音频/视频模态中的无监督聚类结果作为视频/音频模态的监督信号。[52]使用视频和音频的时间同步信息作为自监督信号。

论文二:RWF-2000:

An Open Large Scale Video Database for Violence Detection

mchengny/RWF2000-Video-Database-for-Violence-Detection:一个用于暴力检测的大型视频数据库,其中包含

2,000 个包含暴力或非暴力行为的视频剪辑。

摘要

近年来,监控摄像头在公共场所广泛部署,由于这些无处不在的设备,总体犯罪率已显著降低。通常,这些摄像头会在犯罪发生后提供线索和证据,而很少用于及时预防或制止犯罪活动。手动监控来自监控摄像头的大量视频数据既费时又费力。因此,从视频信号中自动识别暴力行为变得至关重要。

本文总结了几个现有的用于暴力检测的视频数据集,并提出了 RWF-2000

数据库,其中包含监控摄像头在真实场景中捕获的 2,000

个视频。此外,我们还提出了一种同时利用 3D-CNN

和光流优点的新方法,即流门控网络。所提出的方法在我们提出的数据库的测试集上获得了

87.25% 的准确率。数据库和源代码目前对 Access 1 开放。

概述

通常,基于视频的暴力检测的定义是检测视频数据中的暴力行为。它是人类动作识别的一个子集,旨在识别常见的人类动作。与静止图像相比,视频数据具有额外的时间序列。一组连续的帧表示连续的运动,而相邻的帧由于帧间相关性高而包含冗余信息。

一些早期的方法依赖于检测高度相关物体(例如,枪击、火焰、血腥、爆炸)的存在,而不是直接识别暴力事件

此前数据的劣势:尽管存在一些用于暴力检测的视频数据集,但它们仍然存在规模小、多样性少和图像分辨率低的缺点。此外,一些具有高图像质量的相关数据集来自电影,这些电影与真实场景不够接近。为解决真实暴力活动中高质量数据不足的问题

本文工作:

为了解决真实暴力活动中高质量数据不足的问题,我们收集了一个新的视频数据集

(RWF-2000)

并将其免费发布给研究界。该数据集规模较大,包含从监控视频中提取的 2,000

个剪辑

我们提出了一种新的具有自学习池机制的模型,该模型可以很好地兼顾外观特征和时间特征。

先前数据集

根据注释方法,仍然存在两种用于暴力检测的视频数据集:修剪和未修剪。裁剪后的数据集中的视频都是几秒长的短片,每个视频都有一个视频级标注。而视频未修剪的数据集通常具有更长的持续时间。此外,暴力活动的开始时间和结束时间都有帧级注释。

总结这些提议的数据集,每个数据集都至少具有以下一个或多个限制:

图像质量低;缺乏足够的数据量

视频时长但注释粗糙

与现实暴力不够接近的视频混合来源

为了解决上述问题,我们从 YouTube 网站收集了一个新的 RWF

2000(真实世界格斗)数据集,其中包括 2,000

个由监控枪式摄像机从真实场景中拍摄的修剪视频剪辑。

先前方法

传统方法通常会尝试找到一个 powfer

特征提取算法,并实现一个基于机器学习的分类器来完成暴力检测任务。

总之,基于深度学习的方法通常优于传统的基于特征提取的模型。此外,大多数最先进的结果都使用多通道输入(例如,原始

RGB 图像、光流、加速度图)。同时,复杂模型对过拟合不是很鲁棒。

在本文中,我们只采用 RGB

图像和光流来构建神经网络,它可以处理空间和时间信息。此外,我们提出的

Flow-Gated

架构可以通过自学习来减少输入视频的时间通道,而不是传统的池化策略。

RWF-2000 数据库和建议的方法

数据采集

为了使暴力检测在现实应用中更加实用,我们从 YouTube

平台收集了一个新的真实世界格斗 (RWF)

数据集,其中包含监控摄像头在真实场景中拍摄的 2,000 个视频剪辑。

拟议的数据集有 2,000 个视频剪辑,分为两部分:训练集 (80%) 和测试集

(20%)。一半的视频包含暴力行为,而其他视频属于非暴力活动。

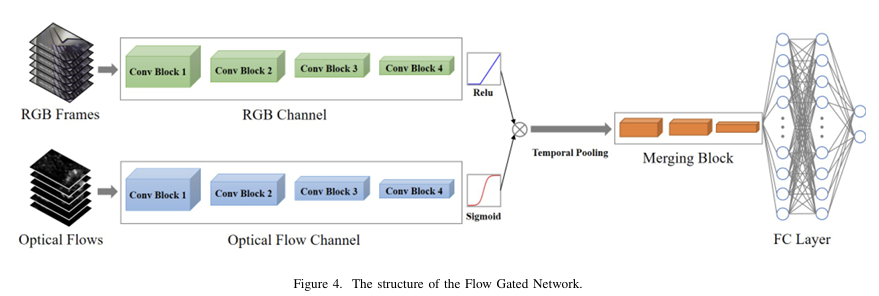

Flow Gated Network

以前的大多数方法都探索从单个帧中提取外观特征,然后将它们融合以对时间信息进行建模。由于粗略的池化机制,运动信息可能毫无用处,我们的目标是设计一种通过网络自学习实现的时间池化机制

asdasf

由四个部分组成:RGB 通道、光流通道、合并块和全连接层。RGB

通道和光流通道由级联的 3D CNN

组成,它们具有一致的结构,因此它们的输出可以融合。Merging Block

也由基本的 3D CNN 组成,这些 CNN

在自学时间池化后处理信息。最后,全连接层生成输出。

该模型的亮点是利用光流通道的一个分支来帮助构建池化机制。

后续学习

基于YOLOv8/YOLOv7/YOLOv6/YOLOv5的暴力行为检测系统(深度学习模型+UI界面+Python代码+训练数据集)-CSDN博客

YOLO8实战:暴力行为检测系统_yolov8

打架检测-CSDN博客

参考文献

科研分享|视频异常检测_哔哩哔哩_bilibili

[领域综述] TPAMI

2022 | Human Action Recognition from Various Data Modalities: A Review -

知乎

RWF-2000

暴力行为检测视频数据集 - 知乎

另一个暴力行为数据集XD-暴力